深度研究:用加密激励众筹一个 AI 模型,可行吗?

作者:Jeff Amico

编译:深潮TechFlow

引言

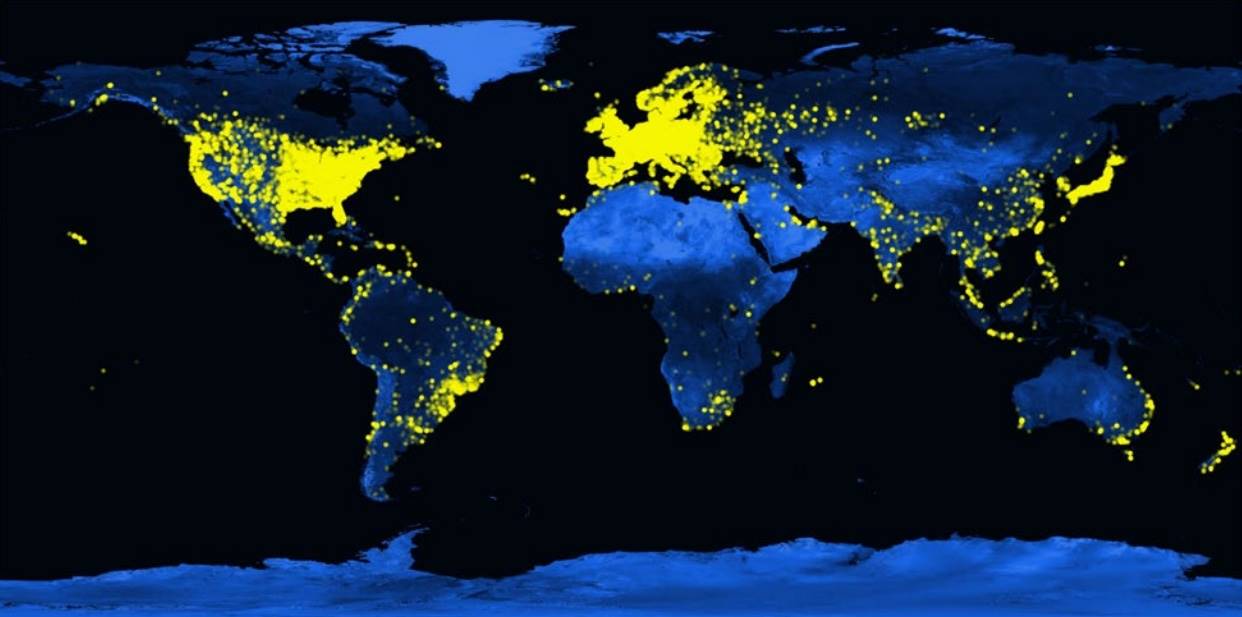

在新冠疫情期间,Folding@home 取得了一个重大里程碑。该研究项目获得了 2.4 exaFLOPS 的计算能力,由全球 200 万台志愿者设备提供。这代表了当时世界上最大超级计算机的十五倍处理能力,使科学家能够大规模模拟 COVID 蛋白质动态。他们的工作推动了我们对病毒及其病理机制的理解,尤其是在疫情初期。

Folding@home 用户的全球分布,2021

Folding@home 基于志愿计算的悠久历史,项目通过众包计算资源来解决大规模问题。这个想法在 1990 年代的 SETI@home 中得到了广泛关注,该项目汇集了超过 500 万台志愿者计算机以寻找外星生命。此后,这一理念已被应用于多个领域,包括天体物理学、分子生物学、数学、密码学和游戏。在每种情况下,集体力量增强了单个项目的能力,远远超出了他们单独能够实现的范围。这推动了进步,使研究能够以更开放和合作的方式进行。

许多人想知道我们是否可以将这一众包模型应用于深度学习。换句话说,我们能否在大众中训练一个大型神经网络?前沿模型训练是人类历史上计算最密集的任务之一。与许多 @home 项目一样,目前的成本超出了只有最大参与者才能承担的范围。这可能会阻碍未来的进展,因为我们依赖于越来越少的公司来寻找新的突破。这也将我们的 AI 系统的控制权集中在少数人手中。无论你对这项技术的看法如何,这都是一个值得关注的未来。

大多数批评者驳斥了去中心化训练的想法,认为与当前的训练技术不兼容。然而,这种观点已经越来越过时。新的技术已经出现,能够减少节点间的通信需求,从而允许在网络连接不佳的设备上高效训练。这些技术包括 DiLoCo 、 SWARM Parallelism 、 lo-fi和异构环境中基础模型的分散训练等多个技术。其中许多具有容错性,并支持异构计算。还有一些新架构专为去中心化网络设计,包括 DiPaCo 和去中心化混合专家模型。

我们还看到各种加密原语开始成熟,使得网络能够在全球范围内协调资源。这些技术支持数字货币、跨境支付和预测市场等应用场景。与早期的志愿项目不同,这些网络能够汇聚惊人的计算能力,通常比目前设想的最大云训练集群大几个数量级。

这些要素共同构成了新的模型训练范式。这种范式充分利用全球的计算资源,包括如果连接在一起可以使用的大量边缘设备。这将通过引入新的竞争机制来降低大多数训练工作负载的成本。它还可以解锁新的训练形式,使得模型开发变得协作和模块化,而不是孤立和单一的方式。模型可以从大众中获取计算和数据,实时学习。个人可以拥有他们所创建模型的一部分。研究人员也可以重新公开分享新颖的研究成果,无需通过货币化他们的发现来弥补高昂的计算预算。

- 申链财经

免责声明:投资有风险,入市须谨慎。本资讯不作为投资建议。